Heute gilt MLPerf als der wichtigste Deep Learning Benchmark. Dies zeigt sich auch in der zunehmenden Zahl großer Technologieunternehmen, die um die weltweite Nummer 1-Position hinsichtlich der Trainingsgeschwindigkeit ihres KI-Systems konkurrieren.

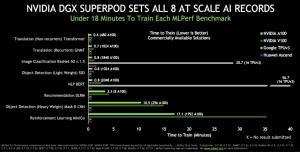

Nvidia gab heute bekannt, dass es 16 AI-Leistungsrekorde bei MLPerf-Benchmarks gebrochen hat (NVIDIA stellte auch bei den ersten MLPerf-Ausbildungsbenchmarks im Dezember 2018 sechs und im Juli 2019 acht Rekorde auf).

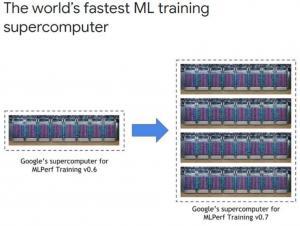

All diese großen Technologieunternehmen prahlen mit ihren „KI-Supercomputern“, vor allem aber mit ihrer Spitzenposition in MLPerf, wobei viele Blogs über ihren Erfolg unmittelbar nach der Ankündigung von MLPerf schreiben, ähnlich wie ich gerade. Ich bin der Meinung, dass MLPerf damit beginnen sollte, nicht nur Präzision und Trainingszeit, sondern auch Energieverbrauch und Energiekosten als Metriken in ihrer Leistungsbewertung zu berücksichtigen.

Nur wenn es keinen Schaden für die Umwelt (durch den CO2-Ausstoß dieser riesigen Computers) und die Wirtschaft (enorme Training und Inferenz Kosten) gibt, und wenn die MLPerf integrativer sein wird, werden wir sehen, wer der wahre Held Nr. 1 ist.

Neueste Kommentare